Undervisningsmaterialer

Stor sprogmodel

Find dit næste undervisningsmaterialer til filosofi med børn og unge eller kunstig intelligens, som inkluderer temaet ‘Stor sprogmodel’.

Teksten er skabt med tekst-til-tekst-generatoren Claude Sonnet og derefter gennemlæst og revideret af Martin Kongshave. Alle “tags” er skabt på denne måde, da de blot har til formål, at pege på et tema, som du kan finde i de pågældende læremidler. Læremidlerne er skabt superduper autentisk af Tankespirerne.

Store sprogmodeller repræsenterer et paradigmeskift inden for kunstig intelligens, hvor massive neurale netværk trænes på enorme mængder tekstdata for at generere og forstå naturligt sprog. Disse modeller opererer gennem sandsynlighedsbaserede forudsigelser af næste ord eller token i en sekvens, baseret på den foregående kontekst. Konceptet udfordrer vores forståelse af sprogforståelse, kreativitet og kognition. Det rejser fundamentale spørgsmål om forholdet mellem statistisk læring og semantisk betydning, om grænserne for maskinbaseret sprogbrug, og om implikationerne for menneske-maskine interaktion og kommunikation.

En person skriver en e-mail, cursor blinker efter hvert ord. Forslag til næste ord dukker op, nogle præcise, andre overraskende. Skribenten pauser, overvejer forslagene, vælger nogle, ignorerer andre. I denne stille dialog mellem menneske og maskine udspiller sig et komplekst samspil af intention, prædiktion og valg, hvor grænsen mellem menneskelig og kunstig kreativitet bliver stadig mere flydende.

Andrew Ng, en pioner inden for maskinlæring, fremhæver betydningen af data og skalerbarhed i udviklingen af store sprogmodeller. Ng argumenterer for, at disse modellers styrke ligger i deres evne til at lære mønstre og sammenhænge fra enorme datamængder, hvilket muliggør en hidtil uset grad af sproglig nuance og kontekstforståelse. Han understreger dog også vigtigheden af etisk brug og bias-kontrol i træningsdata. Andrej Karpathy, tidligere direktør for AI hos Tesla, udforsker de tekniske detaljer bag store sprogmodeller. Han beskriver dem som “autoregressive modeller”, der forudsiger næste element i en sekvens baseret på de foregående elementer. Karpathy fremhæver, hvordan disse modeller gennem deres træning opbygger en implicit forståelse af sprogets struktur og semantik, uden eksplicit programmering af grammatiske regler. Både Ng og Karpathy’s indsigter inviterer os til at overveje, hvordan disse modeller udfordrer vores opfattelse af sproglig intelligens og kreativitet, og hvordan de potentielt kan omforme vores interaktion med teknologi og information.

Tankespirernes undervisningsmaterialer understøtter en dialogisk, kritisk tænkende, undersøgende og kerende klassekultur, hvor børn og unge kan forme deres holdning og stillingtagen til de vigtigste filosofiske og teknologiske spørgsmål i deres tilværelse og i skolefagene.

Drøm op sprog med en chatbot

Handout fra Rantzausminde-projektet

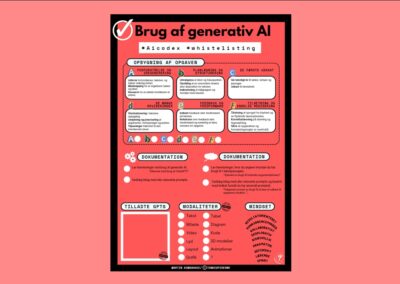

Rammesat brug af generativ AI

ChatGPT søger job som skolemakker

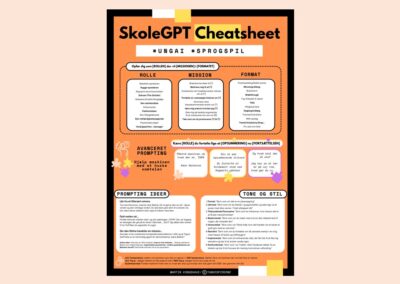

Prompting i fiktionens verden – SkoleGPT Cheatsheet